구글 연구팀이 사진 1장과 음성을 입력함으로써 음성에 맞춰 손짓 발짓을 섞어 말하는 리얼한 동영상을 생성할 수 있는 AI 프레임워크 ‘VLOGGER’를 발표했다고 과학기술매체 기가진이 보도했다.

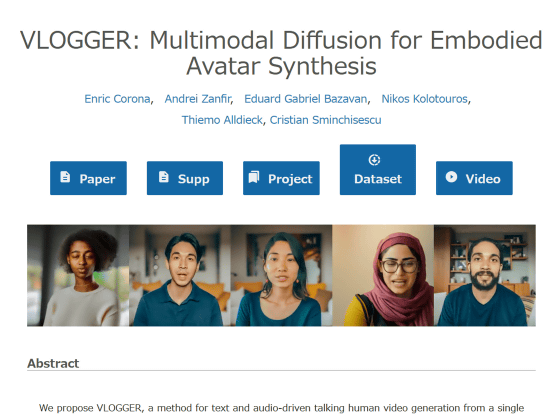

이 보도에 따르면, 구글 리서치에서 인체 3D와 생성 AI 연구를 하고 있는 엔릭 코로나 이끄는 연구팀은 확산 모델이라 불리는 기계학습 모델의 일종을 활용해 ‘VLOGGER’를 개발했다.

VLOGGER에서 동영상을 생성하기 위해서 필요한 것은 기본이 되는 이미지 데이터와 거기에 맞춘 음성 데이터다. 최초의 네트워크에서는 음성 데이터로부터 취득된 파형 데이터를 기본으로 해, 인물의 시선•표정•포즈로 이루어지는 ‘바디 모션 컨트롤(body motion controls)’가 작성된다. 이어 네트워크에서는 대규모 이미지 확산 모델을 확장해 입력 이미지에서 바디 모션 컨트롤에 대응하는 프레임을 생성하는 구조다.

VLOGGER 개발의 열쇠가 된 것은 80만 명 분 이상의 다양한 아이덴티티와 합계 2200시간을 넘는 동영상을 포함하는 ‘MENTOR’라고 하는 데이터 세트다. 이 방대한 데이터 세트로 훈련함으로써, VLOGGER는 다양한 민족•연령•복장•포즈•주변 환경을 바이어스를 섞지 않고 동영상으로서 생성할 수 있게 됐다고 한다.

동영상는 짧고 자세히 보면 어색한 부분도 있는 것으로 평가된다. 그러나 연구팀은 “VLOGGER를 세 가지 다른 벤치마크로 평가한 결과, 제안된 모델이 화질, 동일성 유지, 시간적 일관성에서 다른 최첨단 기법을 능가하는 것으로 나타났다”고 주장했다.

또 “선행연구와는 대조적으로 우리의 기법은 각 개인의 훈련을 필요로 하지 않고 얼굴 검출이나 트리밍에 의존하지 않고 얼굴이나 입술뿐만이 아닌 완전한 이미지를 생성하고 의사소통하는 인간을 올바르게 합성하기 위해 중요한 폭넓은 시나리오(눈에 보이는 몸통이나 다양한 피험자의 정체성)를 고려하고 있다”고 덧붙였다.

(참고 : enriccorona.github.io/vlogger)